Common Crawl

Pesquisadores descobriram cerca de 12.000 segredos válidos, incluindo chaves de API e senhas, no conjunto de dados Common Crawl, que é amplamente usado para treinar vários modelos de inteligência artificial.

A organização sem fins lucrativos Common Crawl mantém ativamente este enorme repositório de código aberto, que contém petabytes de dados da web coletados desde 2008. Além disso, é livremente acessível a qualquer pessoa.

Devido ao vasto tamanho deste conjunto de dados, muitos projetos de inteligência artificial dependem fortemente dele — pelo menos em parte — para treinar grandes modelos de linguagem (LLMs). Notavelmente, empresas como OpenAI, DeepSeek, Google, Meta, Anthropic e Stability alavancaram esse arquivo digital para seus modelos.

Chaves raiz da AWS e chaves da API do MailChimp

Pesquisadores da Truffle Security, a empresa por trás do scanner de código aberto TruffleHog para dados confidenciais, identificaram segredos válidos após analisar 400 terabytes de dados de 2,67 bilhões de páginas da web no arquivo Common Crawl de dezembro de 2024.

Durante a investigação, eles descobriram 11.908 segredos que foram autenticados com sucesso. Essas descobertas sugerem que os desenvolvedores tinham credenciais codificadas, levantando preocupações sobre os riscos potenciais de treinar modelos de linguagem grandes (LLMs) em código inseguro.

É importante observar que os dados de treinamento de LLM não permanecem em sua forma bruta. Em vez disso, eles passam por um estágio de pré-processamento que inclui limpeza e filtragem de dados irrelevantes, duplicatas, conteúdo prejudicial e informações confidenciais.

No entanto, apesar dessas precauções, remover completamente os dados confidenciais continua sendo um desafio significativo. O processo não fornece nenhuma garantia de que um conjunto de dados dessa escala será totalmente despojado de informações de identificação pessoal (PII), dados financeiros, registros médicos ou outro conteúdo confidencial.

Após analisar os dados escaneados, a Truffle Security confirmou a presença de chaves de API válidas para os serviços Amazon Web Services (AWS), MailChimp e WalkScore.

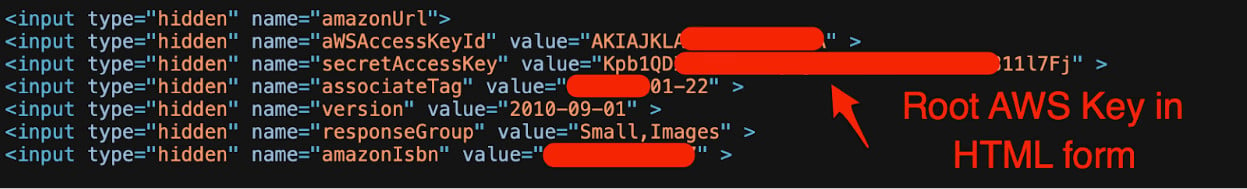

Chave root AWS em HTML front-end

fonte: Truffle Security

TruffleHog identificou um total de 219 tipos de segredos distintos dentro do conjunto de dados Common Crawl, com as chaves da API MailChimp sendo as mais comuns.

“Quase 1.500 chaves exclusivas da API do MailChimp foram codificadas em HTML e JavaScript front-end”, relatou a Truffle Security.

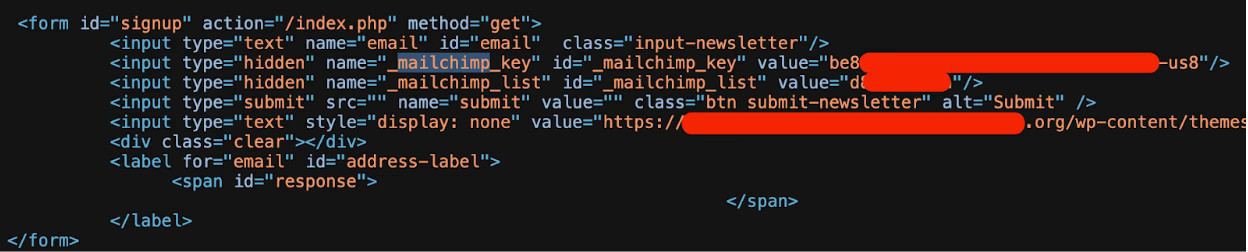

Chave da API do MailChimp vazou no HTML do front-end

fonte: Truffle Security

De acordo com os pesquisadores, esse problema surgiu quando os desenvolvedores incorporaram erroneamente essas chaves diretamente emformulários HTML e trechos de JavaScript em vez de usar variáveis de ambiente do lado do servidor.

Como resultado, os invasores podem explorar essas chaves expostas para atividades maliciosas, como campanhas de phishing e representação de marca. Além disso, o vazamento desses segredos aumenta o risco de exfiltração de dados.

Outra descoberta crítica no relatório destaca a alta taxa de reutilização desses segredos expostos. Na verdade, 63% apareceram em várias páginas. Um exemplo marcante foi uma chave de API do WalkScore, que apareceu 57.029 vezes em 1.871 subdomínios.

Os pesquisadores também descobriram uma página da web contendo 17 webhooks exclusivos do Slack — credenciais que devem permanecer privadas, pois permitem que os aplicativos publiquem mensagens nos canais do Slack.

“Mantenha segredo, mantenha-o seguro. A URL do seu webhook contém um segredo. Não o compartilhe on-line, inclusive por meio de repositórios públicos de controle de versão”, Slack avisa.

E agora?

Após sua pesquisa, a Truffle Security entrou em contato com os fornecedores afetados e colaborou com eles para revogar as chaves comprometidas.

“Ajudamos com sucesso essas organizações a girar/revogar coletivamente vários milhares de chaves”, declararam os pesquisadores.

Mesmo que um modelo de inteligência artificial seja treinado em conjuntos de dados mais antigos do que o analisado neste estudo, as descobertas da Truffle Security servem como um lembrete crítico: práticas de codificação inseguras podem influenciar diretamente o comportamento de LLMs.

Fonte: BleepingComputer, Ionut Ilascu